AIサーバーにおけるメモリコスト構造の推定

- 結論:HBMの価格とMUのM/Sを考慮すれば、国内社に大きく不利ではない

DRAMBOMの割合が低いため、Micronが最も劣位にあるという内容です。

"Micron looks very weak in AI"

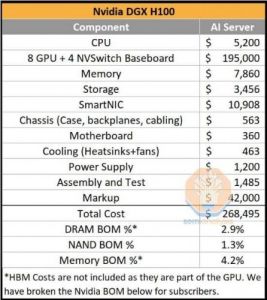

- GPUに取り付けられたHBMを除くDRAMのBOM Costは$7,860(2.9%)

- HBM2Eの場合は12ドル/GB、HBM3の場合は14ドル/GB

- H100の場合、HBM 80GBを基本的に装着

- DGX H100でのHBM Cost = 8GPU x 80GB HBM x 14ドル/GB = $8,960

- - DGX H100의 Total DRAM = HBM + DRAM = $16,820 = 6.3% of BOM

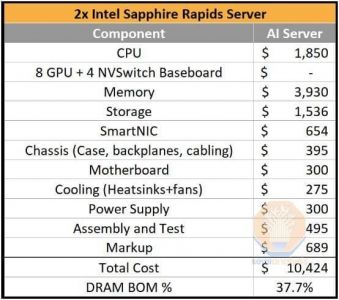

- Sapphire Rapids ServerでのDRAM BOM=$3,930と比べると約4倍のDRAM Cost消耗

- 従来のサーバーDRAMにおける市場シェアSKハイニックス39%、サムスン電子35%、Micron25%とは異なり

- HBMにおける23F市場シェアはSKハイニックス48%、サムスン電子43%、Micron9%まで考慮すると

- Sapphire Rapids Serverにおけるサムスン電子+SKH Share = $3,930 x 81% = $3,183

- DGXにおけるSamsung電子+SKH Share=$16,820 x 91% = $15,360で5倍以上のEffect有

- DGX Serverの価格は従来のServerに比べて約27倍高いが、単純互換関係ではないが他の変数を統一した仮定の下で、

- Service Providerの立場でDGX一つを投資するためにCapexが負担になり、Sapphire Rapidsserverの購入を1/5に減らさない限り

国内DRAM社に有利な環境

AI 서버에서 메모리 비용 구조 추정

219

ツイートLINEお気に入り 162

162 47

47