AIサーバー1台に3億ウォン

エヌビディア GPU H100 8個入り(1個3000万ウォン)

DRAMはDDR52テラバイト(約5000万ウォン)

GPUベースのサーバー出荷推薦2023年364万台→2025年463万台

HBMの長所

- TSVで実装面積の縮小、データ転送速度4倍、消費電力50%削減(vs GDDR6)

- GPUスペック競争に核心

- Auto、AI側で採用され本格的な成長局面に突入

顧客企業との協業

- インテルEMIBでHBM接続

- AMD、SKハイニックスとHBM共同開発、データセンター用GPUにはHBMのみ活用

- NVIDIA、地道にHBMを搭載、GPU H100にはHBM3を搭載

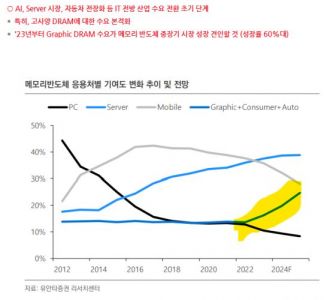

- AI、Surver市場、自動車電装化などIT前方産業需要転換初期段階

- 特に、高仕様DRAMに対する需要本格化

- 23年からGraphic DRAM需要がメモリー半導体中長期市場の成長を牽引する(成長率60%台)

DDR5 DRAM 現在の価格128GB基準 1200ドル マージン率50%以上

2025年DDR5市場シェア90%突破

AI시대 삼성전자 엄청난 수혜

32

ツイートLINEお気に入り 25

25 6

6