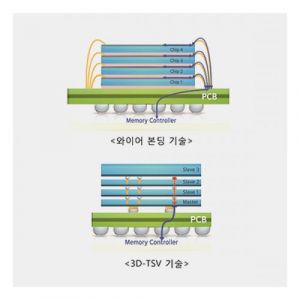

現在、AIサーバーには大容量のデータを高速で処理するためにHBMだけでなく、一般DRAMモジュールにも少なくとも128GB以上のDDR5-5600製品が搭載されている。 しかし、従来のWire Bondingパッケージングでは16Gbチップを積み重ねると4800以上の速度が出せない。 それでTSVパッケージングでChipを積んでこそAIサーバー専用DRAMモジュールを作ることができる。 ところでTSV技術力がマイクロンは大きく遅れてあの製品を作れない。 早くても来年末になってようやく進入可能。 AIのおかげでHBMだけでなく、あのモジュール製品も収益性がとても良い。 営業利益率がほぼ50%に迫る。 それでTSVアドバンスドパッケージングがAI時代に必須だということだ。

第2四半期のDRAM3社出荷量増加の見通し

第1四半期比

サムスン電子+20%

SKハインニクス +50%

マイクロン+10%未満を予想

AI、サーバー向メモリに強い順に出荷量が増加。 特にマイクロンは中華圏顧客会社離脱の影響もある。 これにより、第2四半期のハニック·ディーラムの市場シェアはほぼ30%に迫り、逆にマイクロンのシェアは20%台もやや負けそうだ。

「今年第4四半期からサムスン電子は北米GPU業者にHBM3供給開始が本格化するものと期待される」として「したがってサムスン電子全体DRAM売上でHBM3が占める売上比重は2023年6%から2024年18%まで拡大が予想される」と分析した。

続けて「特にAIサーバーに搭載されるHBM3価格は既存メモリー半導体対比5倍以上高く、今後5年間AIサーバー市場が年平均+25%成長(既存サーバー年平均成長率+5%)するものと見られ中長期サムスン電子DRAM収益性改善要因として作用する展望」と明らかにした。

고성능 D램 기술 한국이 독식

131

ツイートLINEお気に入り 93

93 21

21